Von der Analytical Engine zur KI

15. Juni 2020 | In diesem fiktiven Beitrag erzählt »Ada Lovelace« die Geschichte der digitalen Datenverarbeitung

Adas Geschichte als Podcast

Die Geschichte von Ada Lovelace können Sie als Podcast anhören.

Den Podcast hat Isabel Pogner erstellt, Sprecher sind Jan Micha Nietsch, Isabel Pogner und Heiko Wörrlein.

Datenschutz und Datenverarbeitung

Wir setzen zum Einbinden von Videos den Anbieter YouTube ein. Wie die meisten Websites verwendet YouTube Cookies, um Informationen über die Besucher ihrer Internetseite zu sammeln. Wenn Sie das Video starten, könnte dies Datenverarbeitungsvorgänge auslösen. Darauf haben wir keinen Einfluss. Weitere Informationen über Datenschutz bei YouTube finden Sie in deren Datenschutzerklärung unter: https://policies.google.com/privacyAdas Geschichte

In unserer modernen Welt übernehmen Chips die Speicherung und Verarbeitung von Daten. Würde man alle Chips über Nacht wegnehmen, hätten wir von morgens bis abends Probleme. Schon das Frühstück wäre ein Problem, denn im Toaster und in der Kaffeemaschine steckt ein Chip. Wir kämen nicht mehr zur Arbeit, denn viele Autos würden nicht mehr fahren. Und die älteren, die es noch tun, würden nicht weit kommen, da die Ampeln ausfallen. Und sind wir endlich bei der Arbeit angekommen, würde dort wohl auch nichts mehr funktionieren. Außer man arbeitet ohne Technik. Und wer tut das heutzutage schon?

Chips sind in unserem Leben also selbstverständlich. Jedoch weiß kaum einer, was das eigentlich ist – ein Chip.

Wir begeben uns auf die historische Reise der Datenverarbeitung.

Es begann alles mit Ada Lovelace...

Hallo! Ich bin Ada. Freut mich, dass wir uns kennen lernen. Ich bin mittlerweile über 200 Jahre alt und schon vielen interessanten Menschen und deren Erfindungen begegnet. Das neueste Highlight: Die Kollegen des Fraunhofer IIS haben ihr Center für Analytics, Daten und Anwendungen nach mir benannt. Das ADA Lovelace Center. Ich fühle mich sehr geehrt und lasse die Menschen des 21. Jahrhunderts gerne teilhaben an einem Rückblick auf die Geschichte der Datenverarbeitung.

Ich wurde am 10. Dezember 1815 in London geboren. Meine Mutter hat mich alleine groß gezogen. Sie hat Naturwissenschaften geliebt! Und natürlich hat sie mich auch darin unterrichten lassen.

Mein Mann später war auch Wissenschaftler. Er hat mich sehr bei meiner Forschung unterstützt. Zum Beispiel hat er Artikel in der Bibliothek der Royal Society für mich abgeschrieben, weil Frauen dort damals nicht erlaubt waren.

Ich war aber nicht nur eine leidenschaftliche Wissenschaftlerin, sondern auch liebende Mutter. Meinen drei Kindern habe ich abends immer auf der Harfe vorgespielt.

Ich habe die Datenverarbeitung von meiner eigenen Forschung bis heute verfolgt, und möchte Ihnen davon erzählen.

Ich habe, als ich 28 Jahre alt war, die Beschreibung der »Analytical Engine« des Mathematikprofessors Charles Babbage ins Englische übersetzt. Ursprünglich hatte der spätere Ministerpräsident Italiens – Luigi Menabrea – eine Zusammenfassung von einem von Charles‘ Vorträgen auf Französisch verfasst. Ein Bekannter von Charles bat mich dann, den Text ins Englische zu übersetzen. Da Charles wusste, dass ich seine Maschine gut verstanden habe, schlug er vor, dass ich den Bericht um eigene Gedanken erweitere. Meine »Notes« waren am Ende allerdings doppelt so umfangreich wie der Artikel selbst. Da steckte schon viel Herzblut von mir drin. Die Notes beschreiben das erste Computerprogramm. Damit bin ich die erste Informatikerin, denn ich habe das weltweit erste Programm entwickelt.

Außerdem habe ich einen Plan entwickelt, wie man mit der Maschine die Bernoulli-Zahlen berechnen kann. Allerdings wurde die Analytical Engine nie gebaut. Obwohl spätere Wissenschaftlerinnen und Wissenschaftler belegten, dass sie funktioniert hätte. Damals war die Feinmechanik noch nicht weit genug entwickelt. Außerdem wollte das britische Parlament nicht so viel Geld für den Bau ausgeben.

| Bernoulli-Zahlen: Die Bernoulli Zahlen sind eine Abfolge rationaler Zahlen, die in verschiedenen mathematischen Zusammenhängen immer wieder auftreten. 1, ±1⁄2, 1⁄6, −1⁄30, etc. |

Die Analytical Engine – die erste Idee einer programmierbaren Rechenmaschine

Dabei war das Konzept eigentlich echt cool: 19 Meter lang und drei Meter hoch sollte die Analytical Engine werden. Sie sollte komplett mechanisch mit Zahnrädern funktionieren – angetrieben von einer Dampfmaschine. Sie sollte addieren, subtrahieren, dividieren und multiplizieren können. Mit Lochkarten hätte man Befehle eingeben können. Eine Glocke hätte Signale übermittelt und ein Lochkartendrucker die Ergebnisse ausgespuckt. Die Maschine sollte immerhin 1000 Zahlen mit 30 Dezimalstellen speichern können, was einer Speichergröße von circa 12 Kilobyte entspricht. Ein heutiges, handlungsübliches Smartphone hat etwa 5 Millionen mal so viel Speicher.

Naja, schade für Charles und mich, dass die Maschine nie gebaut wurde, aber wir sind ja nicht in Vergessenheit geraten: Viele weitere Entwicklerinnen und Entwickler wurden von uns maßgeblich beeinflusst. Nun aber weiter in der Geschichte...

Zuse Z3 – der deutsche mechanische Universalrechner

Im Zweiten Weltkrieg arbeiteten beide Kriegsgegner auf Hochtouren daran, aufwändige Berechnungen von Maschinen durchführen zu lassen.

In Deutschland entwickelte Konrad Zuse 1941 mit der Z3 den Prototyp eines programmierbaren Universalrechners. Verbaut waren darin ca. 2000 elektromechanische Schalter, genannt Relais. Die Zuse sollte im Krieg komplizierte Berechnung im Bereich der Luftfahrt durchführen.

Ich halte ja überhaupt nichts vom Krieg. Aber die Erfindung an sich war interessant:

Die Zuse 3 war der Analytical Engine eigentlich unterlegen. Denn sie konnte nur 64 Gleitkommazahlen mit 22 Bit Genauigkeit berechnen. Aber sie war eben nicht nur ein Konzept, sondern wurde wirklich gebaut. Sie lebte allerdings nur drei Jahre: 1944 wurde sie bei einem Bombenangriff zerstört.

Ein Jahr später wurde die Zuse 4 gebaut. Die Z4 überstand den Krieg und kam später an die Eidgenössisch Technische Hochschule ETH nach Zürich, wo meine Kollegen sie weiter verbesserten.

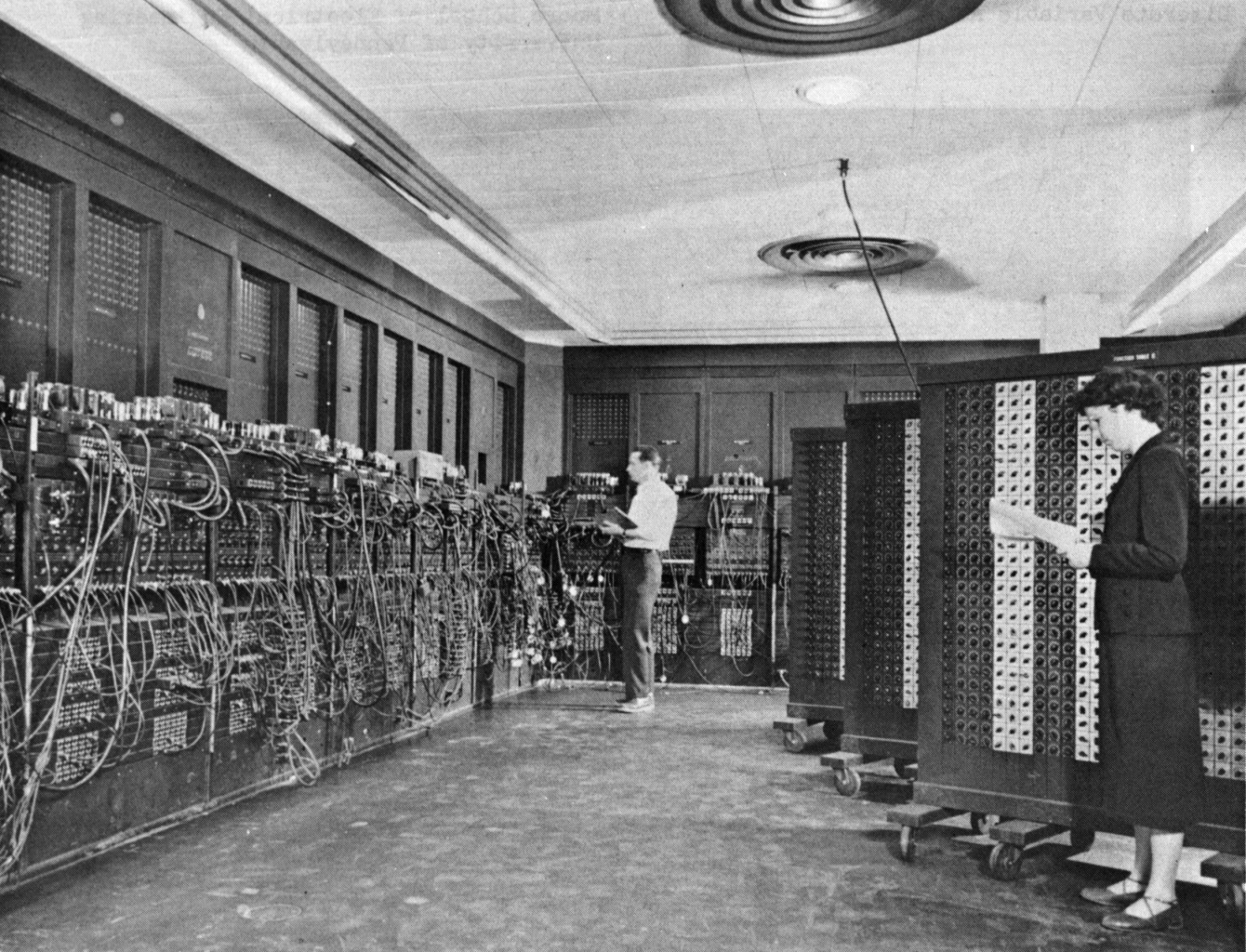

Der ENIAC – der erste elektronische Universalrechner

Die Amerikaner haben 1942 den ersten elektronischen Universalrechner entwickelt: Den »Electronic Numerical Integrator and Computer« – kurz ENIAC. Auch ENIAC musste für den Krieg arbeiten und ballistische Tabellen für Kanonen berechnen.

Der ENIAC war 10 mal 17 Meter lang und wog 27 Tonnen. In mein Wohnzimmer hätte der ENIAC also sicher nicht gepasst. Auch die Stromrechnung hätte ich nicht zahlen wollen: Seine 17 468 Elektronenröhren hatten einen Stromverbrauch von etwa 175 kW. Genauso viel Strom brauchen so circa 90 voll aufgedrehte Herdplatten.

Der ENIAC konnte addieren, subtrahieren, multiplizieren, dividieren und Quadratwurzeln ziehen. Seine Elektronenröhren arbeiteten wesentlich schneller als mechanische Relais. Dadurch schaffte er immerhin 5000 Additionen in der Sekunde. Programmiert wurde der ENIAC aber sehr umständlich: Man musste die Teile einzeln mit Kabeln verbinden und auf Drehschaltern einstellen, was man errechnen wollte. Im Krieg programmierten sechs Ladys den Computer: Die ENIAC-Frauen. Diese Mathematikerinnen leisteten Pionierarbeit.

Eine von ihnen war Betty Jennings Bartik, genannt Jean. Nach ihrem Mathematikabschluss in Missouri riet man ihr, Lehrerin zu werden. Das war ihr aber zu langweilig, sie wollte Abenteuer erleben. Und die bekam sie auch: Sie war maßgeblich am Beginn der modernen Software-Branche beteiligt. Und somit ein Teil an der Veränderung der Welt, wie wir sie damals kannten.

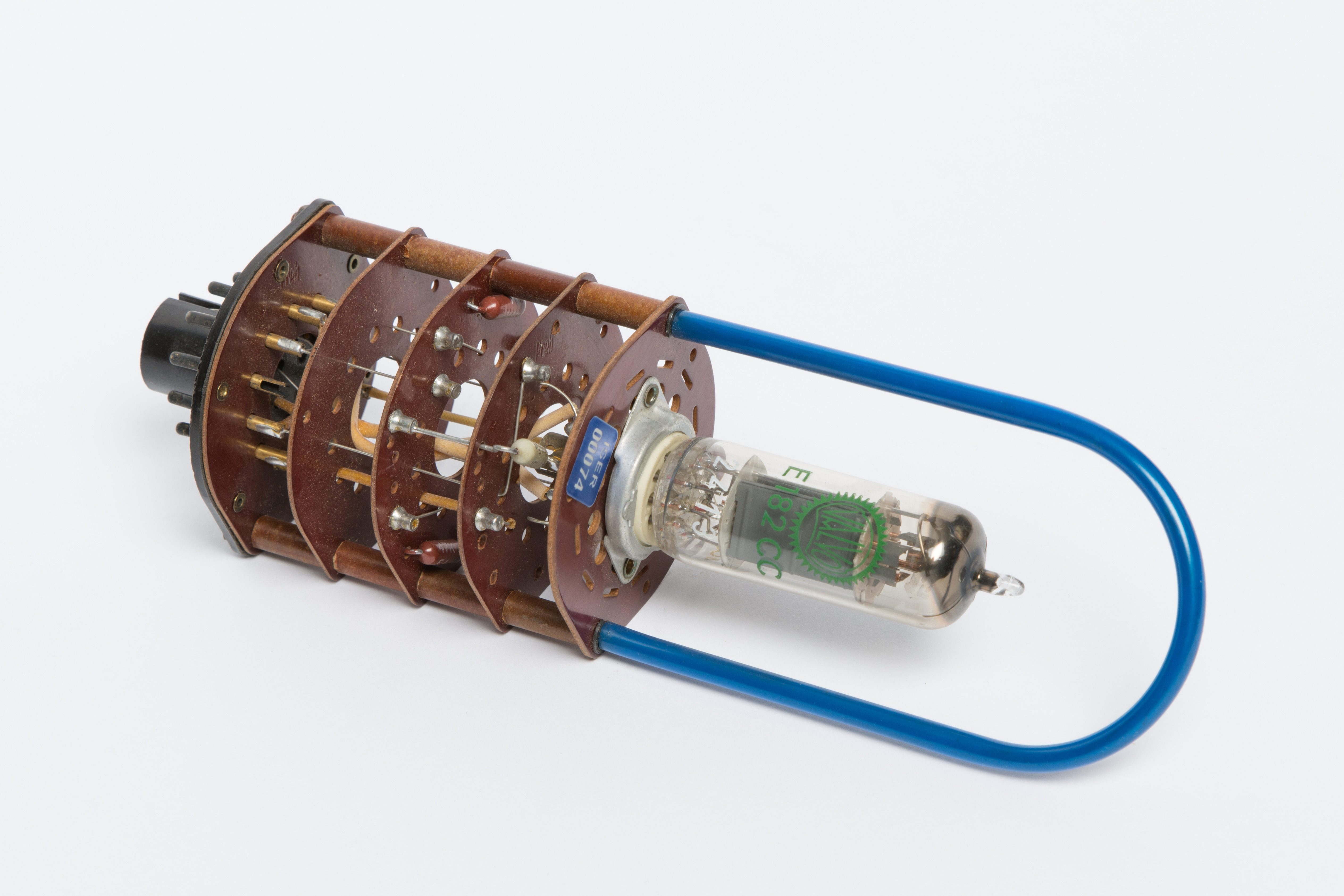

Die Elektronenröhre – Startschuss zur Schaltung

Die einfachste Form der Elektronenröhre ist die Triode. Diese besteht aus einem luftleeren Glaskolben, der drei Elektroden enthält. Von der elektrisch beheizten und glühenden Kathode fliegen Elektronen zur Anode. Der dritte Anschluss, das Steuergitter, kann diesen Elektronenstrom beeinflussen. Man muss dazu eine Spannung am Steuergitter anlegen. Damit kann man aus der Triode entweder einen Schalter oder einen Verstärker basteln. In der Röhre bewegt sich nichts. Deshalb arbeitet sie viel schneller als elektromechanische Relais. Allerdings waren die Dinger sehr empfindlich. Hin und wieder sind die Kathoden einfach durchgebrannt.

Schon bei einer einzigen defekten Röhre rechnete das Elektronenhirn falsch. Und der hohe Stromverbrauch erforderte eine starke Kühlung. Kein Wunder, dass die Wissenschaftler schnell bessere Lösungen suchten. Und fanden.

Der Transistor – die bessere Alternative

Erforscht und patentiert wurden Transistoren schon 1925. Es dauerte allerdings noch bis 1950, bis dieser Halbleiter alltagstauglich wurde.

Aber was war denn nun eigentlich der Fortschritt? Nun, Transistoren verbrauchen viel weniger Platz, arbeiten schneller, sind mechanisch relativ unempfindlich und benötigen keine Heizung. Dadurch verbrauchen sie weniger Strom und fallen seltener aus.

Die ersten Transistoren waren aus Germanium, später verwendete man Silizium. Zuerst arbeitete man mit dem Bipolartransistor. Der besteht aus drei dünnen Halbleiterschichten, genannt Kollektor, Basis und Emitter. Ein kleiner Strom, der in die Basis fließt, steuert einen großen Strom zwischen Kollektor und Emitter. Je nachdem, wie man den Transistor von außen schaltet, kann er als Verstärker oder – wie im Computer üblich – als Schalter betrieben werden. Zwei sich gegenseitig beeinflussende Transistoren mit ein paar Widerständen bilden dabei die Grundlage für eine Speicherstelle, das sogenannte Flipflop.

Von-Neumann Architektur – wie ist ein Computer aufgebaut?

John von Neumann gab sich diesen sehr amerikanischen Vornamen, nachdem er von Ungarn in die Vereinigten Staaten gezogen war. Ich mag Ungarn mit seinen weiten Sonnenblumenfeldern... Aber wahrscheinlich gab‘s in Amerika bessere Jobs.

John ist ein weiterer geistiger Vater der Informatik. Er war ein Wunderkind und beschäftigte sich schon früh mit Beweistheorien, Quantenmechanik und Spieltheorien. Berühmt wurde er für die Idee zur Von-Neumann- Architektur. Nun, alleine ausgedacht hat er sie sich vermutlich nicht. Aber 1945 formulierte er sie: (räuspern) Ein Computer besteht aus einer Recheneinheit mit schnellem Zwischenspeicher, einer Steuereinheit, externem Speicher sowie Ein-/Ausgabeeinheit. Das Programm für die Steuereinheit und die Daten sitzen im gleichen Speicher. Die schnellen Zwischenspeicher bestanden aus Röhren und später aus Transistoren. Für den externen Speicher war das aber viel zu teuer. Dort benutzte man kleine Ferritringe, die auf dünne Drähte aufgefädelt waren. Das Ganze sah dann aus wie eine Matrix. Die Ringe nennt man auch Magnetkerne. Man konnte die Kerne in zwei Richtungen magnetisieren. Dadurch konnte man die beiden Bit-Zustände 0 und 1 darstellen.

Siemens 2002

Eines der ersten Transistorrechnermodelle weltweit war der Siemens 2002. Er wurde ab dem Ende der 1950er-Jahre hergestellt. In riesigen Schränken steckten viele Baugruppen voll mit einzelnen Transistoren und Widerständen. Voll ausgebaut konnte der Rechner 10 000 Worte zu 12 Dezimalziffern im internen Kernspeicher halten. Statt 5000 Operationen wie der ENIAC schaffte diese Maschine immerhin schon etwa 30 000 Befehle in der Sekunde.

Die Programmiersprache des Rechners entwickelte sich ebenfalls immer weiter fort. Man begann mit der sehr hardware-nahen Assembler-Sprache. Später gab es dann aber auch für Menschen besser verständliche Sprachen wie ALGOL oder FORTRAN.

Der erste Integrierte Schaltkreis

Unsere Geschichte geht in Erlangen weiter.

Werner Jacobi arbeitete bei Siemens in Erlangen. Dort meldete er 1949 den »Halbleiterverstärker« zum Patent an. Der Halbleiterverstärker war eine Schaltung aus fünf Transistoren auf einem einzigen Trägermaterial. Eigentlich war das der erste integrierte Schaltkreis.

Damals blieb der Halbleiterverstärker jedoch weitgehend unbekannt und wurde nicht kommerziell verwendet. Das Nobelpreis-Komitee war der Meinung, dass Jack Kilby die erste integrierte Schaltung erfunden hat. Deswegen wird er »Vater des Mikrochips« genannt. Dafür erhielt er den Nobelpreis für Physik. Da kann man schon neidisch werden...

Jack begann 1958 bei der Firma Texas Instruments zu arbeiten. Da er neu war, bekam er keine Sommerpause. Das fand er bei den texanischen Temperaturen wahrscheinlich nicht so toll. Aber immerhin waren die Labore leer. »Als neuer Angestellter hatte ich noch keinen Urlaubsanspruch, war alleine und hatte reichlich Zeit«, sagte er. Also begann er zu experimentieren. Er widmete sich dem Problem »Tyrannei der Zahlen«. Das Problem war, dass es immer mehr Komponenten in Computern gab, die immer schwieriger zu verdrahten waren. Schließlich kam er zu der Erkenntnis, dass sich das Problem durch die Integration verschiedener Bauelemente in einen einzigen Halbleiter lösen lässt.

In seinem Labortagebuch schrieb er am 24. Juli1958: »Die Idee ist es, Transistoren, Widerstände und Kondensatoren in einem Bauteil zusammenzuführen.«

Zwei Monate später war es dann so weit: Jack präsentierte das erste Exemplar einer funktionierenden Schaltung. Zu sehen war eigentlich nur ein Stück Germanium mit einigen Kabeln auf einem Stück Glas – büroklammergroß. Jack drückte einen Schalter, und die Anwesenden sahen eine Sinuskurve auf einem Oszilloskop.

Beeindruckend war die Präsentation offenbar nicht. Vielleicht war das der Grund dafür, dass die integrierte Schaltung erst keinen großen Erfolg genoss.

Jack setzte seine Erfindung dann beim Bau von Taschenrechnern ein. Die vorherigen Rechenmaschinen waren schreibmaschinengroß und benötigten ein Vielfaches an Rechenzeit.

Zeitgleich zu Jack entwickelte Robert Noyce einen integrierten Schaltkreis. Jack und Robert haben sich deswegen nie gestritten – ihre Firmen Texas Instruments und Fairchild Semiconductor dafür umso mehr. Als Jack dann im Jahre 2000 den Nobelpreis erhielt, war Robert leider bereits tot und bekam deshalb keinen. Aber immerhin hat Robert das Patent für den ersten »monolithischen«, also aus einem einzigen einkristallinen Substrat gefertigten, integrierten Schaltkreis inne.

1960 gelangte die integrierte Schaltung dann bei Texas Instruments und Fairchild Semiconductor in Serienproduktion. Die Schaltungen besaßen damals wenige Dutzend Transistoren. In den nächsten Jahren schoss die Komplexität dann explosionsartig in die Höhe.

Die Zeit der Großrechner

Mikroprozessoren – der Weg zu kompakten Computern

Die ersten Mikroprozessoren wurden 1970 in Serie gebaut. Sie waren handlich und hatten das Steuer- und das Rechenwerk auf einem Mikrochip. Allerdings konnten sie mit den großen Mainframes leistungsfähig nicht mithalten. Sie waren eher zum Einsatz in Tischrechnern gedacht.

Mit dem Mikroprozessor »4004« schaffte Intel den Durchbruch. Dieser Chip war zunächst eine Auftragsentwicklung für einen japanischen Tischrechnerhersteller. Das Ergebnis war der erste universell einsetzbare Mikroprozessor der Welt. Seine Register hatten nur eine Breite von 4 Bit, der adressierbare externe Speicher betrug lediglich 5120 Bit. Aber immerhin vereinte er damals sagenhafte 2300 Transistoren auf einem Chip.

Der japanische Auftraggeber kam kurz darauf in Geldnot und bot Intel den Rückkauf der Rechte am Intel 4004 an. Daraufhin begann Intel mit der eigenen Vermarktung und der Weiterentwicklung dieser Prozessorlinie. Und das sehr erfolgreich. Wie sagt man so schön? Des einen Leid ist des anderen Freud.

Der Superrechner CRAY-1

Moore’s Law – die Komplexität integrierter Schaltkreise verdoppelt sich regelmäßig

Mitte der 1970er passten schon einige tausend Transistoren auf einen Chip. Die Wortbreite der Mikroprozessoren verdoppelte sich auf 8 Bit, der Arbeitstakt verzehnfachte sich. Mit maximal 64 KByte externem Speicher waren wesentlich umfangreichere Programme und Daten möglich. Allerdings hatten die Speicherbausteine immer noch so wenig Fassungsvermögen, dass das ganze Speicherkonstrukt kuchenblechgroß war und ein kleines Vermögen gekostet hat.

Der Intel 8080 und der kompatible, aber leistungsfähigere Zilog Z80 wurden das Herz vieler Heimcomputer. Recht spät stieg 1981 der Hersteller IBM in den Markt der »Personal Computer« ein.

Andere Firmen übernahmen das Konzept. Das Ergebnis: billige Computer, die sich auch Privatleute leisten konnte.

Die Zahl der Transistoren auf dem Chip, sowohl beim Speicher als auch bei den Prozessoren, erhöhte sich immer weiter: Seit 1970 hat sich Zahl der Transistoren pro Chip ungefähr alle zwei Jahre verdoppelt. Die 20- Millionen-Marke ist inzwischen überspringen. Gordon Moore, ein Mitbegründer von Intel formulierte diesen als »Moore’s Law« bekannt gewordenen Zusammenhang schon 1965. Und entgegen allen Erwartungen gilt er heute noch.

Eingebettete Systeme und das Internet der Dinge

ADA Lovelace Center

Nun zurück zum ADA Lovelace Center, auf das ich als Namenspatin natürlich besonders stolz bin.

Im ADA Lovelace Center wird gerade dieser Herausforderung im Umgang mit Daten nachgegangen. Die unterschiedlichsten Lösungen werden erforscht, entwickelt und erprobt. Dabei bleibt es nicht – wie so oft – theoretisch, sondern hat einen klaren Praxisbezug. Für Unternehmen ist es nämlich besonders wichtig, neue datengetriebene Geschäftsmodelle aufzubauen. Das liegt daran, dass Daten heute als der Rohstoff der digitalen Welt gelten. Stellt euch das mal vor! Zu meiner Zeit waren die wichtigsten Rohstoffe noch Kohle, Erz und Stahl…

Datenanalyse, die Auswertung und deren Beherrschung und intelligenter Einsatz ist somit das Erfolgsrezept für Unternehmen im 21. Jahrhundert. Das ADA Lovelace Center hat es sich daher zur Aufgabe gemacht, insbesondere kleine und mittelständische Unternehmen in Bayern zu unterstützen. Forschung zur Künstlichen Intelligenz ist dabei einer der wichtigsten Bereiche. Besonders aber freut mich die Förderung des wissenschaftlichen Nachwuchses, denn es ist besonders wichtig, junge Menschen für dieses Thema zu begeistern.