Vertrauenswürdigkeit als notwendige Voraussetzung für den Einsatz von maschinellem Lernen in der Praxis

Erklärbare KI wird als das zentrale Zukunftsthema der KI-Forschung angesehen, die "3rd Wave of AI" in Nachfolge als Kombination aus wissenbasierten Systemen (1st Wave) und statistischem Lernen (2nd Wave) zu beschreiben. Zunehmend wird deutlich, dass rein datengetriebenes Maschinelles Lernen in vielen Anwendungsbereichen nicht oder nicht ohne Kombination weiteren Methoden einsetzbar ist.

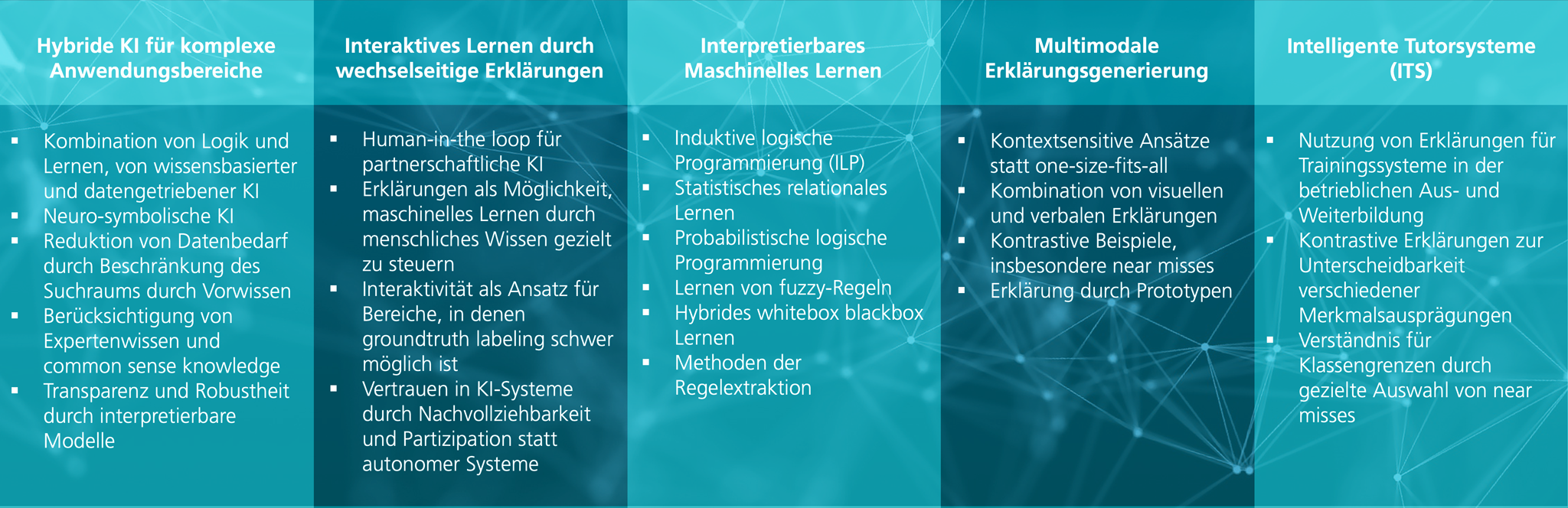

In der Projektgruppe Comprehensible Artificial Intelligence (CAI) entwickeln wir in einer Kooperation des Fraunhofer IIS und der Universität Bamberg Methoden für erklärbares maschinelles Lernen:

- Wir arbeiten an hybriden Ansätzen des maschinellen Lernens, bei denen blackbox Verfahren, wie (tiefe) neuronale Netze mit Methoden des interpretierbaren maschinellen Lernens (whitebox Verfahren) kombiniert werden. Solche Methoden erlauben die Kombination von Logik und Lernen, insbesondere die Berücksichtigung von Expertenwissen beim Lernen.

- Wir entwickeln Methoden des interaktiven und inkrementellen Lernens, für Anwendungsbereiche, in denen nur wenige Daten vorliegen und bei denen das Labeling von Daten problematisch ist.

- Wir entwickeln Algorithmen zur Generierung multimodaler Erklärungen, insbesondere zur Kombination von visuellen und sprachlichen Erklärungen und berücksichtigen dabei Erkenntnisse aus der Kognitionsforschung.

Aktuelle Anwendungsbereiche sind:

- Bildbasierte medizinische Diagnostik

- Mimikanalyse

- Qualitätskontrolle in der Produktion 4.0

- Vermeidung von Biases im Machine Learning

- Phänotypisierung von Nutzpflanzen

- Automotive