Transparente KI-Entscheidungen in der Medizintechnik

Ziel

Ziel des BMBF-Projekts TraMeExCo (Transparent Medical Expert Companion) ist die Erforschung und Entwicklung geeigneter neuer Methoden zum robusten und erklärbaren Maschinellen Lernen (engl. „explainable AI, XAI") auf komplementären Anwendungen (Digitale Pathologie, Schmerzanalyse, Kardiologie) aus dem Bereich der Medizintechnik. Das geplante System soll als Diagnoseunterstützung und Entscheidungshilfe für Ärzte und klinisches Personal dienen.

Partner

Universität Bamberg | Professur für Kognitive Systeme

- An der Universität Bamberg steht die Konzeption, Umsetzung und Erprobung von Verfahren zur Erklärbarkeit von diagnostischen Systementscheidungen mit Local Interpretable Model-agnostic Explanations (LIME), Layerwise Relevance Propagation (LRP) und Inductive logic programming (ILP) im Fokus.

Fraunhofer HHI | Abteilung für Video Codierung & Analyse

- Am Fraunhofer HHI werden die Ansätze von Layerwise Relevance Propagation (LRP) weiterentwickelt.

Fraunhofer IIS | Bereich Smart Sensing and Electronics

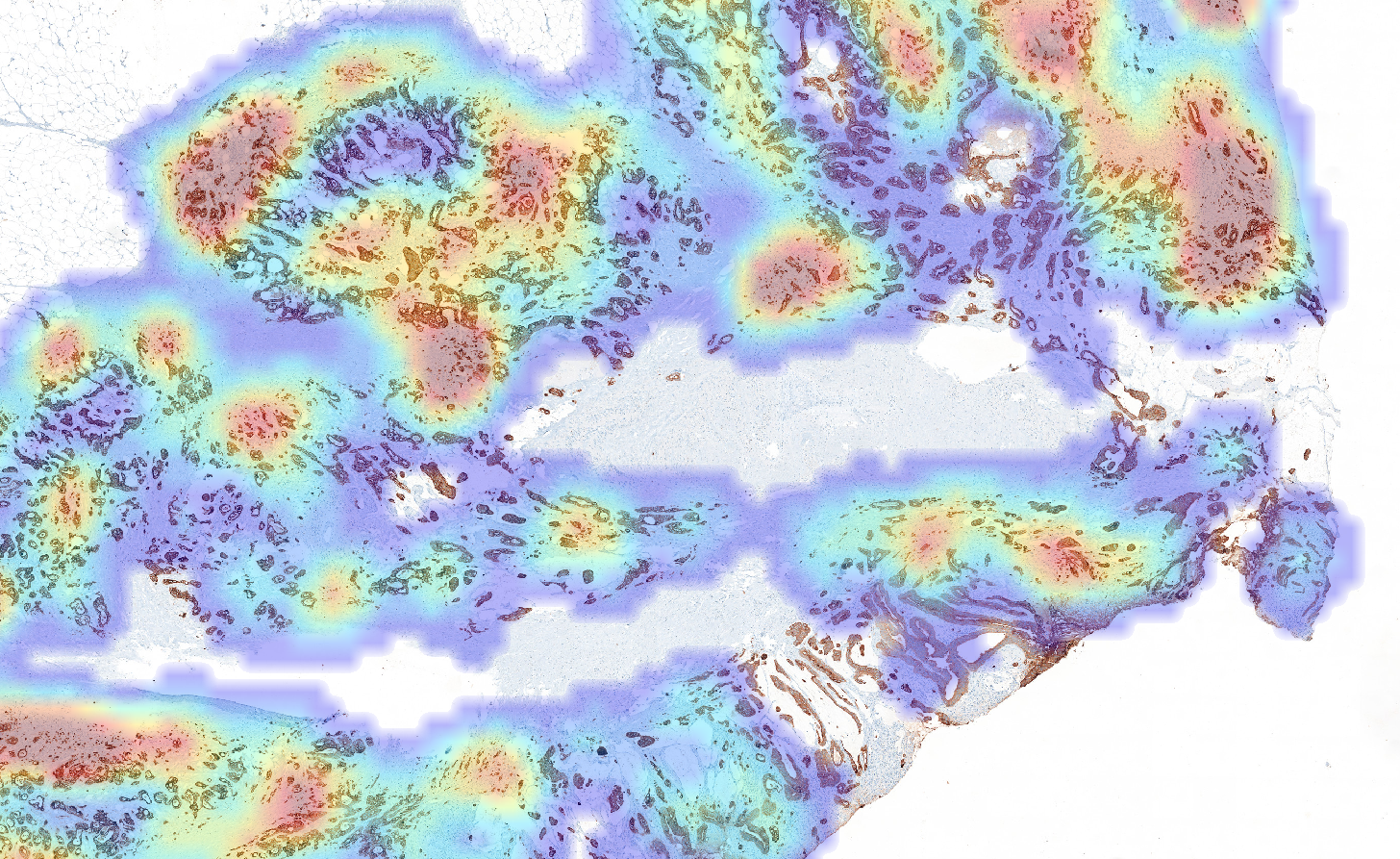

- Im Geschäftsfeld Digital Health Systems werden Ansätze des „Few Shot Learnings“ und „Heat Maps“ für die Digitale Pathologie untersucht und implementiert. „Long-term-Short-term“ Netze dienen der Bestimmung der Herzratenvariabilität auf verrauschten EKG und PGG Daten.

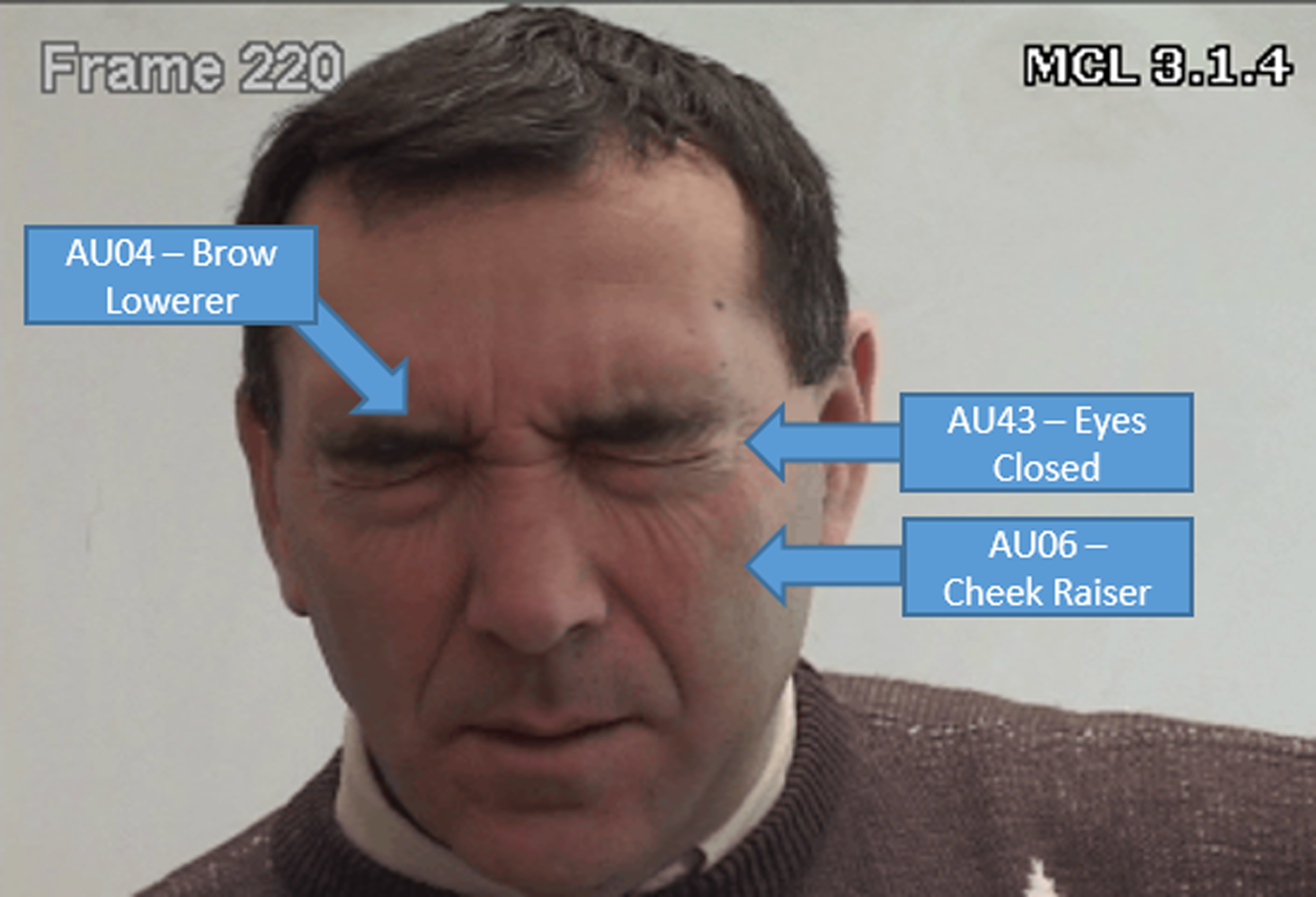

- Im Geschäftsfeld Facial Analysis Solutions werden zusammen mit der Universität Bamberg Verfahren des „Bayesian Deep Learning“ auf Schmerzvideos erforscht. Dabei kommt das sogenannte Facial Action Coding System (FACS) nach Ekman und Friesen zum Einsatz, bei dem jede individuelle Muskelbewegung (Action Unit) wie bspw. das Zusammenziehen der Augenbrauen, beschrieben, interpretiert und erkannt wird. Die automatische Erkennung bestimmter Action Units lässt auf Schmerz schließen.